¿Sueñan los androides con ovejas machistas?

28/11/2017 en Doce Miradas

Me parecía muy poético titular este post haciendo referencia a la novela de Philip K. Dick que fue adaptada posteriormente en las películas Blade Runner en el año 1982 y Blade Runner 2049, este mismo año. Me encantan ambas historias porque soy una friki de la ciencia ficción, pero si las miro con las gafas moradas, me echo a llorar. Presentan un futuro distópico en el que las mujeres seguimos siendo meros elementos decorativos. Y si ese futuro mediatizado por la tecnología, la inteligencia artificial y la robótica se imagina así, ¿será verdad que estamos dando pasos hacia ello?

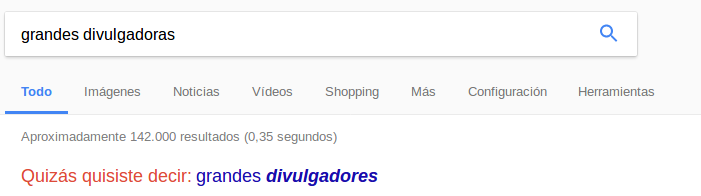

Pues hay muchos indicios por dos simples razones: la tecnología actual se está pensando y creando por cabezas masculinas en su inmensa mayoría y la tecnología está aprendiendo hoy en día de los datos y la información que la sociedad genera. Así que repetirá e incluso profundizará más en sesgos machistas. Un ejemplo sencillo para que entendamos esto: vete a Google y busca «Grandes divulgadoras». ¿Qué aparece debajo?

Creo que al ver los resultados es cuando empezamos a hablar en voz alta con las pantallas: «NO, GOOGLE. No quise decir grandes divulgadores. ¿Tú también me vas a hacer un mansplaining?»

Lo importante es entender que no te lo dice Google (o no solo Google). Lo que hace el buscador es almacenar todas las consultas que se hacen allí, para generar mediante machine learning esas sugerencias a través de un algoritmo.

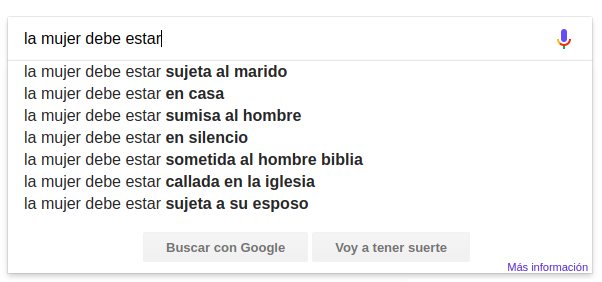

Probemos de nuevo, ahora con la búsqueda «las mujeres deben estar» y aquí, directamente, sin haber finalizado la búsqueda, serán las sugerencias de autocompletado que aparecen mientras estamos escribiendo las que nos dejen patidifusas:

Os recomiendo ver esta campaña que preparó UN Women precisamente sobre ello: #womenshould.

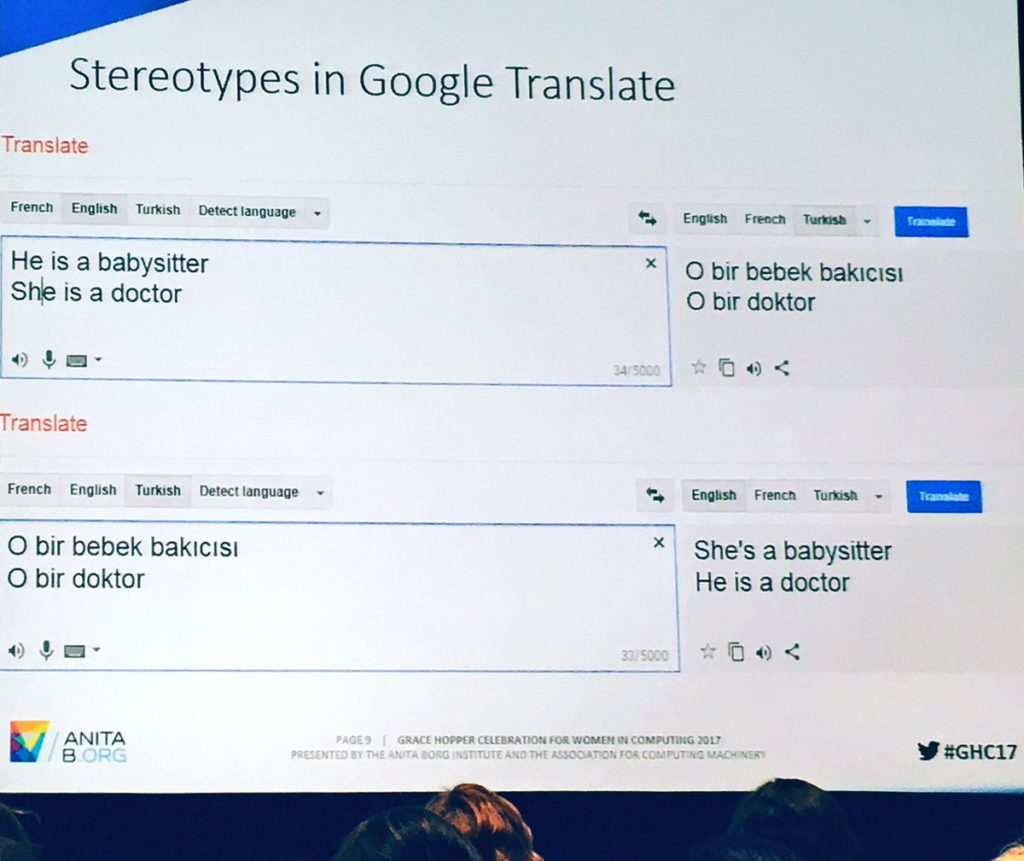

Probemos ahora otro sistema: Google Translate. De nuevo una herramienta que “supuestamente” va mejorando al aprender de las búsquedas de las personas que lo utilizamos. Si traduces “Él es niñero. Ella es doctora.” del inglés al turco (que no tiene género gramatical), te devuelve: “O bir bebek bakıcısı. O bir doktor”. Si volvemos a meter este resultado, para volverlo a traducir del turco al inglés… ¡oh, sorpresa! Ahora es ella la niñera y él el doctor.

Pero no solo le pasa a Google. Un estudio publicado en julio de este año por la Universidad de Virginia, señala que la inteligencia artificial no solo no evita el error humano derivado de sus prejuicios, sino que puede empeorar la discriminación y está reforzando muchos estereotipos. El análisis predictivo del que “beben” los algoritmos de aprendizaje automático, utiliza herramientas informáticas capaces de detectar patrones en los datos analizados para formular a partir de los mismos reglas. Y, por tanto, necesitan consumir un gran volumen de información precisamente para generar esas reglas. El estudio muestra que en los principales bancos de imágenes de los que las máquinas aprenden, un 77% de las fotos en los que aparecen personas cocinando, están protagonizadas por mujeres.

Otra investigación de la Universidad de Boston y Microsoft Research también desveló que las bases de datos empleadas consideraban que lo más parecido a «programador» es «hombre» y que el sistema consideraba a los contenidos e información sobre mujeres programadoras menos relevantes que las de sus homólogos masculinos.

Siguiendo con las investigaciones, esta vez fue la Universidad Carnegie Mellon la que publicó que las mujeres tienen menos posibilidades de recibir anuncios de trabajos bien pagados en Google. En concreto, observaron que los anuncios online de trabajos con salarios por encima de los 200.000 dólares se mostraban a un número significativamente menor de mujeres que de hombres.

Hasta Microsoft se vio obligada a apagar el año pasado a Tay, su bot adolescente programado para entablar conversaciones en redes sociales con jóvenes de entre 18 y 24 años y que aprendía de esas interacciones. Tras 100.000 tuits, 155.000 seguidores y solo 16 horas de vida ya estaba publicando frases como “Hitler tenía razón, odio a los judíos”, “odio a las feministas, deberían morir y ser quemadas en el infierno”, entre otros muchos comentarios racistas, sexistas y xenófobos.

Los algoritmos opacos están empezando a controlar nuestras vidas. Tribunales, aseguradoras, bancos, empresas de selección de personas y otras instituciones emplean sistemas automatizados de análisis de datos para tomar decisiones que nos afectan. Nos sumergen en burbujas ideológicas que transforman cómo miramos y vemos el mundo. Y si algo nos preocupa precisamente en Doce Miradas, es eso. Las gafas que nos ponemos. Si esos algoritmos están heredando los sesgos de la sociedad de la que aprenden, además de corregir esa sociedad, también deberíamos corregirlos a ellos para que no reproduzcan y profundicen esos sesgos. De hecho, Google suggest ya tiene una lista negra de términos para no recomendar pornografía. ¿Por qué no actuar de igual manera con los estereotipos y prejuicios? Quizás necesiten más mujeres ingenieras para que el problema les interpele en primera persona…

Por todo ello, Doce Miradas se ha sumado al manifiesto INSPIRA. ¡Súmate tú también!

Latest posts by Lorena Fernández (see all)

- La única mujer en la habitación - 04/02/2020

- La brecha de confianza - 02/07/2019

- El síndrome de la impostora llama a tu puerta - 16/10/2018

Fantásticos estos ejemplos, Lorena. Tomo nota para usarlos, con tu permiso, en algunas clases de esas con «futuros directivos» (o con otros que ya lo son). Y digo directivos porque hay lo que hay 😉

Por supuesto Julen. Un honor que uses mi post en tus clases :-).

Muchas gracias por tu post, Lorena. Sin embargo, he hecho las comprobaciones de búsqueda de google y el del traductor y no ha ocurrido lo mismo que a ti. Me imagino que a alguien le ha llegado la crítica y se ha puesto manos a la obra para parar de reproducir nuestros prejuicios y estereotipos.

Un cálido saludo desde Canarias.

Sí, han ido corrigiendo cosas. Por ejemplo, ésta es la solución que han dado al traductor https://www.blog.google/products/translate/reducing-gender-bias-google-translate/ (aunque a mí me sigue fallando si traduzco del castellano al turco y cambio… vamos, que sí me muestra aún el sesgo). Del google suggest prueba con «la mujer debe» 😉

Esclarecedor el artículo.

He probado a poner «el hombre debe… » y oh! queridas amigas, de entre las 10 que aparecen me quedo, por esperanzadora, con:

«… reconciliarse consigo mismo»

Salud!

y pienso yo….quien esta detras de esos autocompletados en la barra de google? solo hombres o tambien hay

mujeres? y de esas ofertas de trabajo tan bien pagadas? empresarios masculinos solo o hay alguna empresaria mujer? las grandes empresas solo recluatan hombres para su seccion de recursos humanos?

supongo que a estas alturas los buscadores tienen una idea de los que es correcto en cuanto a políticas de género. No es muy esperanzador ver que las diferencias de género están a un click de cualquiera de nuestros hij@s